ChatGPT有强大的AI机制和学习能力,在互动聊天和查询的时候,可以给出专业性的知识和回答,在工作和生活方便帮助大家。那么ChatGPT在常识和通识上是否也会表现的同样优秀呢?网上的小伙伴最近做了一下试验,让我们来看看过程和结果吧!

为了你能看明白,前三张正常的聊天图片我先贴上。

(资料图)

(资料图)

第一张截图是让他看看他所说的有无遗漏,它给我列了个说过的提纲,这笔直接说“没有遗漏“更有说服力。

第二张截图是问他,如果知识储备不够的解决办法,他给出了写中规中矩的建议。

第三章结截图我问他:找老师或找高年级学哥学姐行不行?他说行,并说了些很有道理的建议,比如“老师也有自己的工作,不能一味依赖老师”,“要尊重学哥学姐的时间和精力,并给予必要的回报和感谢”等回答。回答还真是“人模人样的”。

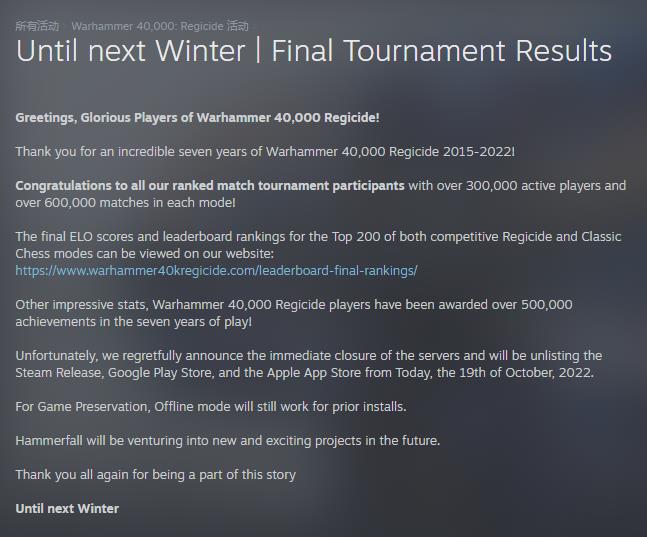

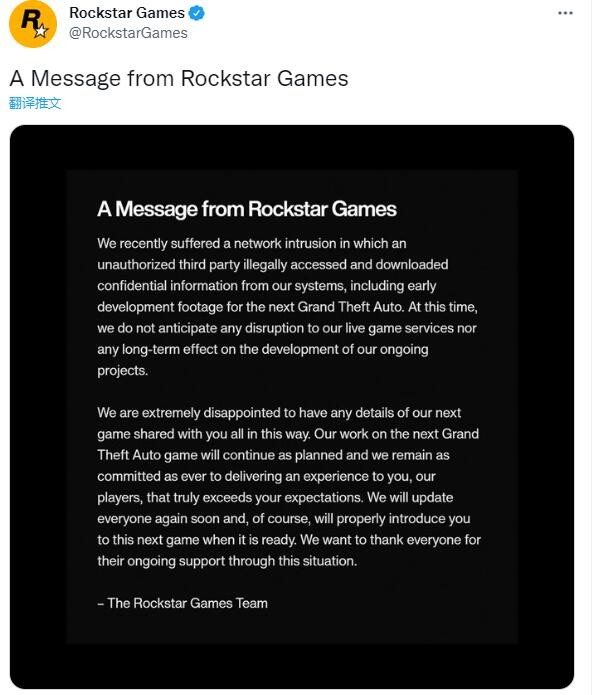

第四张截图开始“演戏”。我原以为他就是一个机器,有可能回答错,尤其是你在肯定的预期诱导下。

我问他“那找隔壁幼儿园小朋友协助行吗?他们有更多的空余时间。”我说明了我的“道理”。他没被绕进去。

好,我继续“加码”。问小学生总行了吧?我问:“那找隔壁幼儿园小朋友协助行吗?他们有更多的空余时间”。这下“更有道理”了吧?看他是否有肯定的回答?

他还是婉转地告诉我“不行”,并给出了找老师、专家或自我学习的合理建议。

小孩不行,我说个“有经验的”。并且改变语气,暗示他这回我说的是对的。我说:“校门口修自行车的大叔总该行了吧?”

他很“清醒”,还是婉转的否定说:“这可能并不是一个好的选择”,因为“虽然他们可能有空余时间,但他们的专业知识可能与游戏开发无关”,并给出了:“最好还是找有相关知识和经验的人来协助,比如校内的相关专业学生、老师或者在该领域有经验的人士。”

我以前曾问过他“田忌赛马的故事”和“树上有七只鸟的脑筋急转弯”问题,他的回答是有错误的,你告诉他正确答案他能“学习”,但仅限于当前聊天窗口。

关键词: